Los experimentos mentales son escenarios imaginarios que nos ayudan a replantearnos nuestras ideas y a elaborar otras nuevas. Son herramientas que han usado científicos, economistas, historiadores y pensadores para provocar “una intuición sincera que haga golpear la mesa”, como escribe el filósofo Daniel Dennett. En esta serie de artículos examinamos algunos de los experimentos mentales filosóficos más conocidos.

El filósofo John R. Searle está encerrado en una habitación en la que van entrando, por una ranura, mensajes con caracteres chinos. Searle no sabe una sola palabra de este idioma, pero consulta un complejo manual en inglés que le indica qué símbolos son los adecuados para responder a los que le llegan. Gracias a este manual es capaz de enviar una respuesta al exterior, donde hay una persona que sí habla chino y que está convencida de que mantiene una conversación en este idioma con el filósofo. ¿Podemos decir que John Searle sabe chino?

Searle (nacido en Denver en 1932) planteó este experimento mental en “Minds, Brains, and Programs”, un artículo publicado en 1980 (pdf). Como explica a Verne Ana Cuevas Badallo, profesora de Filosofía de la Ciencia en la Universidad de Salamanca, el estadounidense respondía así a los defensores de la llamada “inteligencia artificial fuerte”, que defiende que una inteligencia artificial podría igualar o superar la inteligencia humana en cualquier ámbito. Para el filósofo, poder procesar símbolos de modo puramente sintáctico no significa que haya capacidades mentales reales, ya que eso lo da la semántica, es decir, el contenido y la interpretación de ese contenido.

Es decir, un algoritmo no es equivalente al pensamiento consciente y el hecho de que un programa maneje símbolos no significa que comprenda lo que está haciendo.

Las respuestas a Searle: la habitación piensa

El experimento mental de Searle ha sido atacado incluso por aquellos, como el físico Roger Penrose, que están de acuerdo con la conclusión y tampoco creen que una máquina pueda pensar de la misma manera que un cerebro humano. En La nueva mente del emperador, Penrose plantea qué pensaríamos si, en lugar de un solo hombre, dentro de la habitación hubiera miles o millones de personas ejecutando tareas. ¿La situación no sería entonces comparable a lo que ocurre en un cerebro y esas personas no se podrían asimilar a las neuronas? Y si en este caso nadie sugiere que las neuronas “saben chino” (o francés, o matemáticas, o conducir), ¿por qué esperar que cada una de estas personas sí lo sepan?

Otra respuesta habitual es la de que se trata de un problema de sistemas. Ese hombre que está dentro de la sala no sabe chino, pero toda la sala, como sistema, sí conoce el idioma. Según escribe escribe Dennett en Bombas de intuición, es lo que ocurre en el caso de una máquina: el software por sí solo no puede hacer nada y un procesador vacío, tampoco, pero ambos juntos pueden ganarme al ajedrez, por ejemplo.

La respuesta de Searle a este argumento es una ampliación del experimento: supongamos que el filósofo no está en una habitación, sino al aire libre. Y que no tiene el manual ni la base de datos de caracteres, sino que lo ha memorizado todo. En este caso, ya no habría “sistema” (la habitación) y él podría simular un diálogo por escrito en chino. Pero seguiría sin comprender el idioma: “Manipular los símbolos es una cosa, comprender su significado es otra”, escribe en Mind: A Brief Introduction (La mente: una breve introducción).

¿Importa que una máquina sea consciente?

Una de las ideas que ataca Searle con este experimento es el test de Turing, según el cual una máquina se podría considerar inteligente si una persona no supiera si está hablando con un ordenador o con otro interlocutor. Searle considera que su habitación podría pasar este test y hacer creer a los demás que sabe chino. Aunque no tenga ni idea.

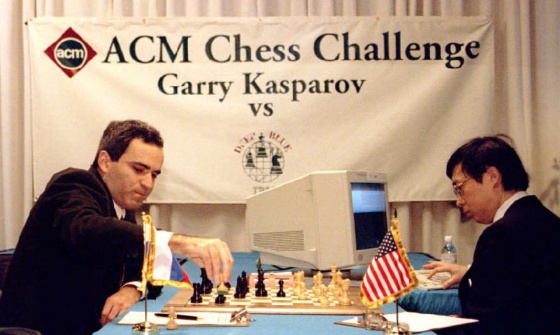

Sin embargo, el matemático británico Alan Turing (1912-1954) escribió en el artículo donde habla de su test (pdf) que la pregunta “¿pueden pensar las máquinas?” no tiene sentido y no merece la pena discutirla. Lo importante para él es si nosotros podríamos darnos cuenta de la diferencia. Por ejemplo, ¿importa que la computadora Deep Blue y la IA Alpha Go tengan conciencia de lo que están haciendo, o solo importa que hayan ganado a los campeones humanos de ajedrez y de go?

Nos puede parecer que da igual si una máquina solo imita o si de verdad piensa y siente. Pero Cuevas Badallo recuerda que la existencia de consciencia y la naturaleza de los fenómenos mentales son asuntos que tienen más implicaciones de lo que pueda parecer.

De entrada, la forma en la que deberíamos tratar a estas máquinas conscientes quizás debería ser muy diferente. Yo puedo tirar una calculadora a la basura, pero si esa calculadora siente dolor y me pide por favor que no acabe con su vida, la situación cambia. La filósofa pone el ejemplo de los robots que podrían diseñarse como trabajadores o incluso como juguetes sexuales. Si tienen consciencia y sentimientos, ¿cómo debemos tratarles? ¿Tendrán derechos? ¿Podremos obligarles a hacer algo que no quieran? Por otro lado, ¿cómo sé que esa calculadora siente miedo por su vida o solo está programada para simularlo?

Cuevas Badallo recuerda que un debate similar ya se dio con los animales. El problema de la relación entre mente y cuerpo arranca en filosofía moderna con Descartes, explica, y este filósofo francés creía que un perro o un gato no sentían ni pensaban, como -en su opinión- probaba el hecho de que no tuvieran lenguaje. Si un carro atropella a un perro, puede parecer que el perro sufre, pero para el francés solo es una ilusión: lo mismo que si creyéramos que el carro siente dolor porque hace ruido al quebrarse la madera.

En este contexto, la profesora recuerda que una de las funciones de la filosofía es la de ayudarnos a darnos cuenta de las implicaciones que tienen ideas y argumentos que parecen obvios. No es lo mismo que una máquina sienta de verdad o que solo imite un comportamiento, como apuntábamos. La filosofía también puede recordarnos las limitaciones de nuestros argumentos, como, por ejemplo, nuestra visión antropocéntrica, en la que ignoramos que puede haber más de una manera de ser consciente, como ocurre con los animales... Y como podría pasar con las máquinas.

Según Cuevas Badallo, el experimento de Searle cumple muy bien esta función de ofrecer argumentos y de poner en duda conceptos y suposiciones. Y eso con independencia de si estamos de acuerdo o no con su conclusión de que no es lo mismo procesar información que comprenderla. “Se sigue enseñando porque es un argumento muy bueno frente a quienes quieren reducir las capacidades mentales a un mero algoritmo”, explica. “La propuesta de Searle levantó un montón de reflexiones sobre algo que a muchos les parecía obvio y esa es una de sus virtudes”.

Otros experimentos mentales:

El barco de Teseo: lo que una embarcación reconstruida nos enseña sobre la identidad

* También puedes seguirnos en Instagram y Flipboard. ¡No te pierdas lo mejor de Verne!